PatchTST

~

16 October 2024

~

开源项目

算法介绍

A Time Series is Worth 64 Words: Long-term Forecasting with Transformers (PatchTST):PatchTST是一种高效的基于Transformer的多变量时间序列预测与自监督表示学习模型,核心在于时间序列的子序列分割和通道独立性设计。子序列分割保留了局部语义信息,显著降低了计算和内存需求,并扩展了历史信息的覆盖范围。通道独立性使单变量时间序列共享嵌入和权重,提高了模型效率和泛化能力。

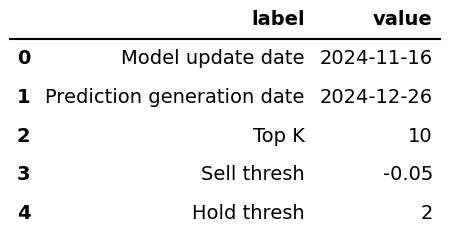

模型信息

模型更新日期和预测日期:

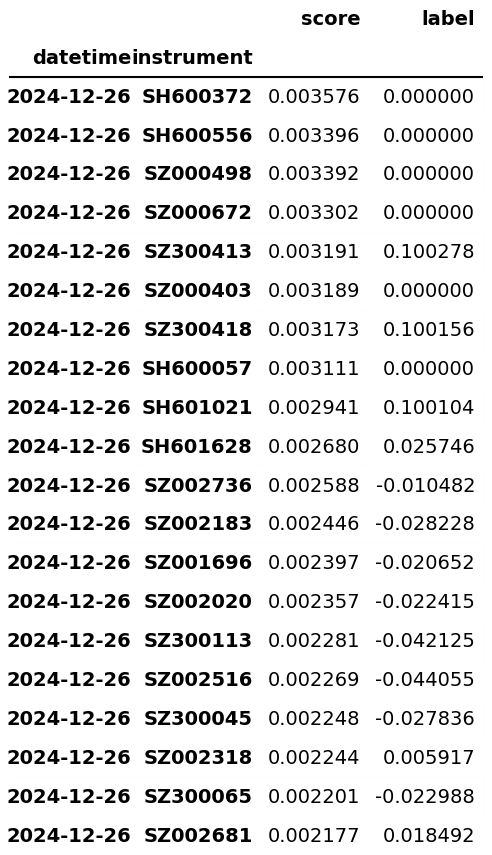

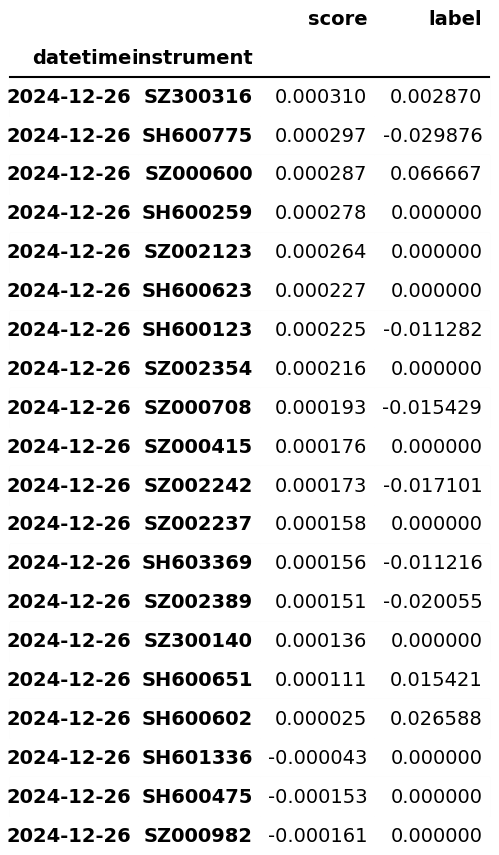

信号预测结果

未来1日信号预测排序前10:

未来1日信号预测排序末10:

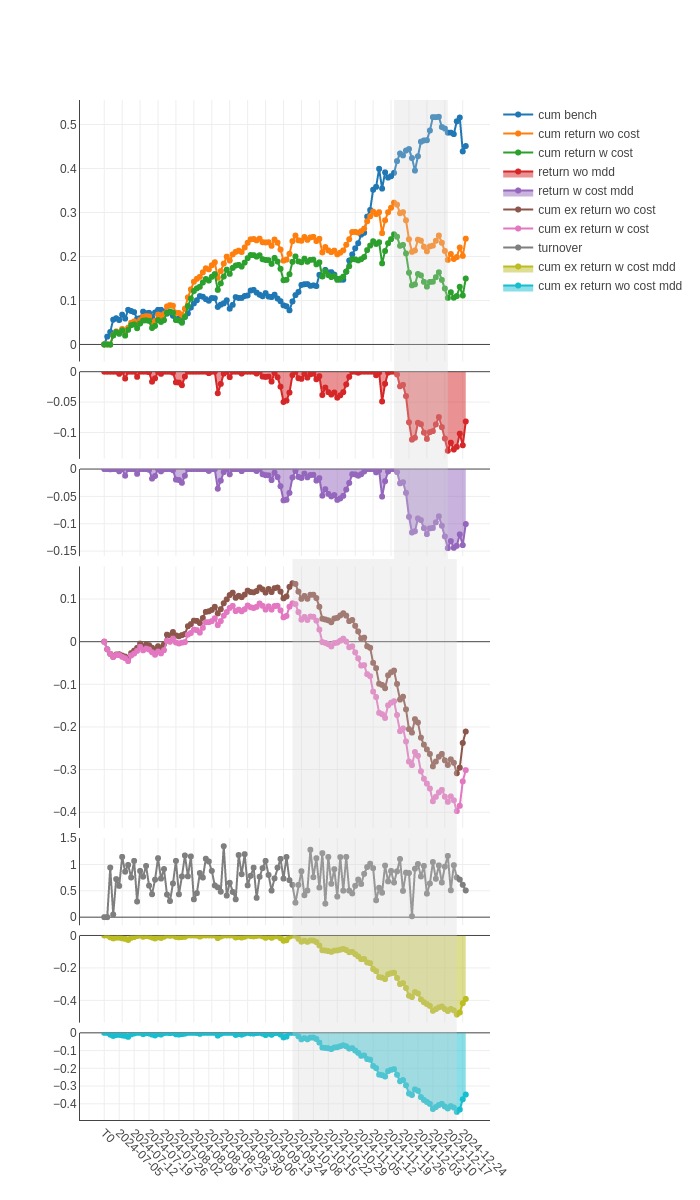

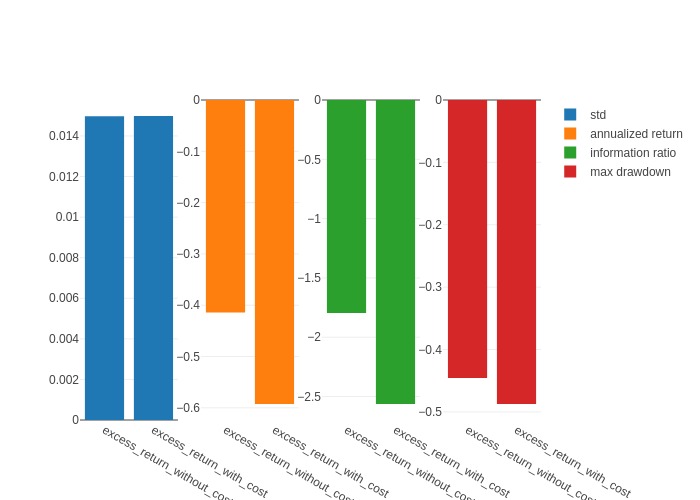

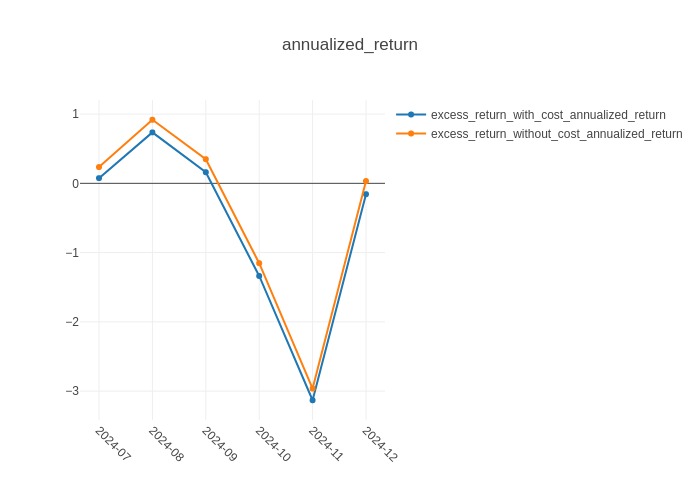

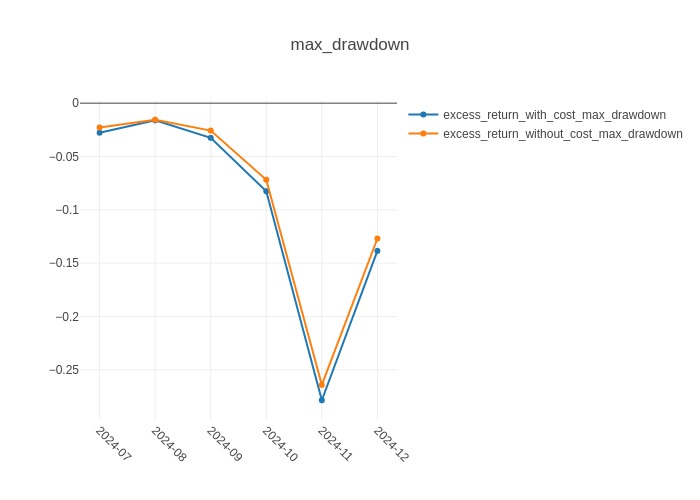

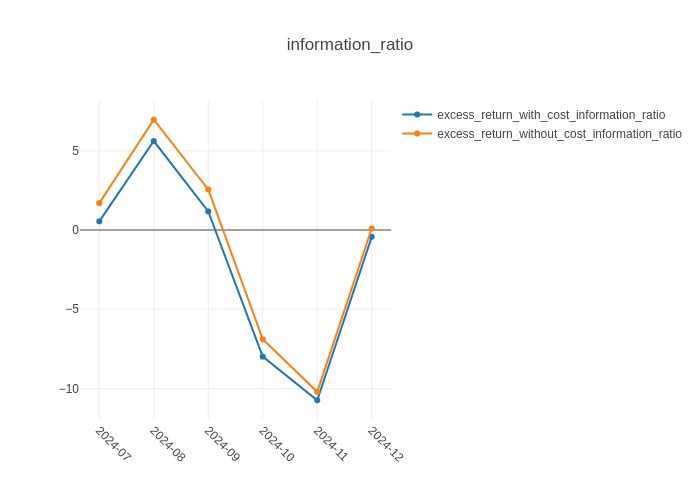

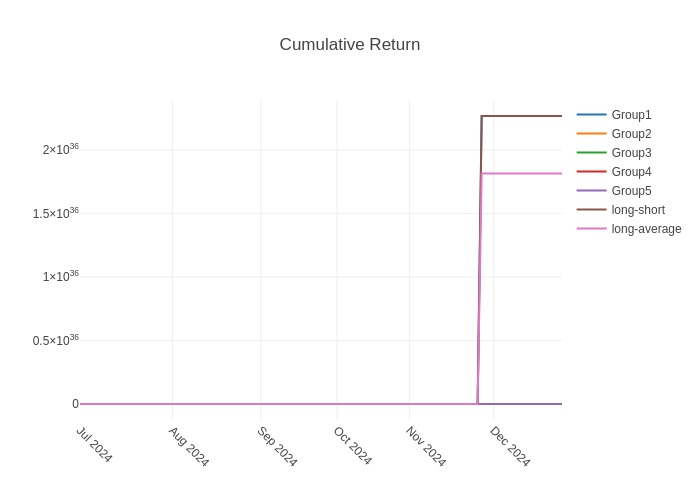

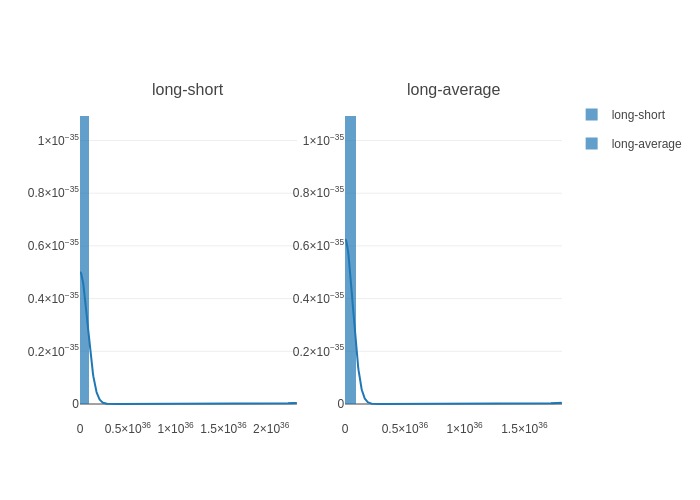

回测结果报告

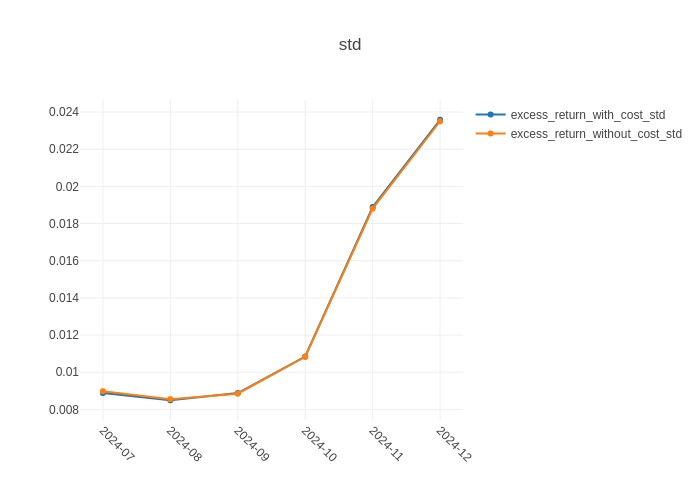

风险分析报告

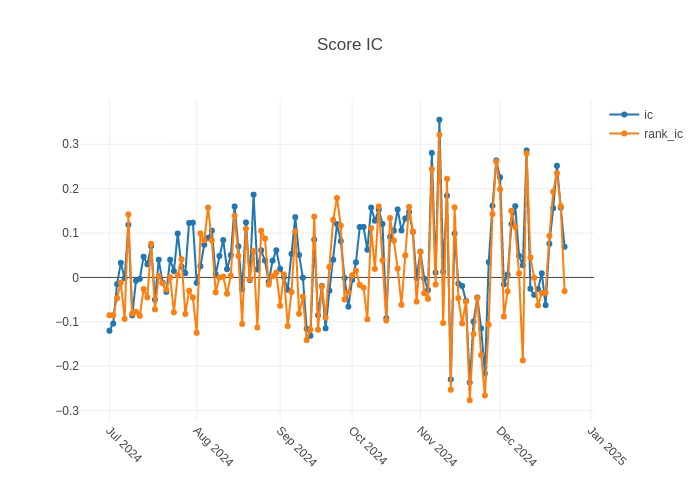

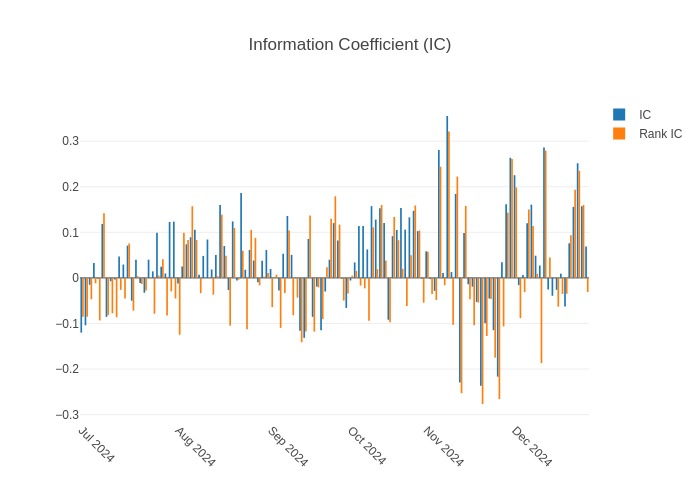

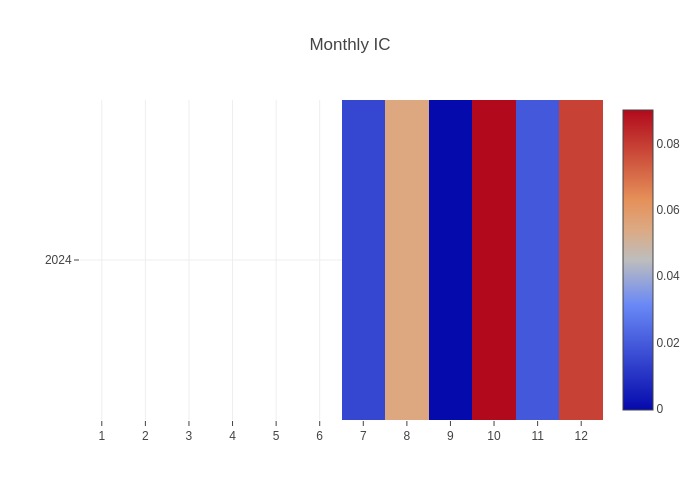

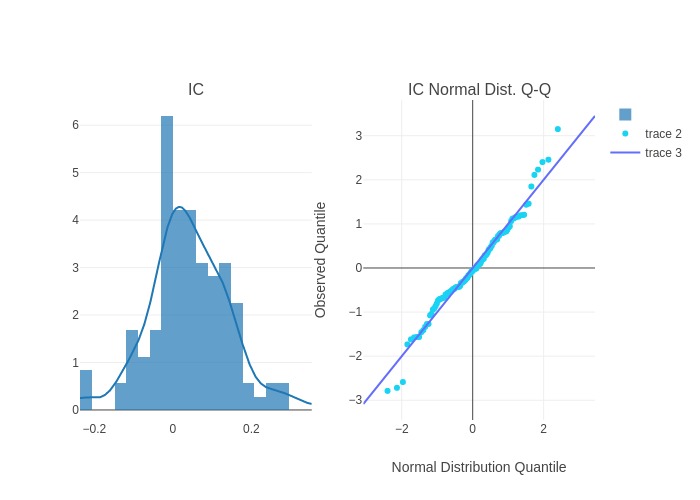

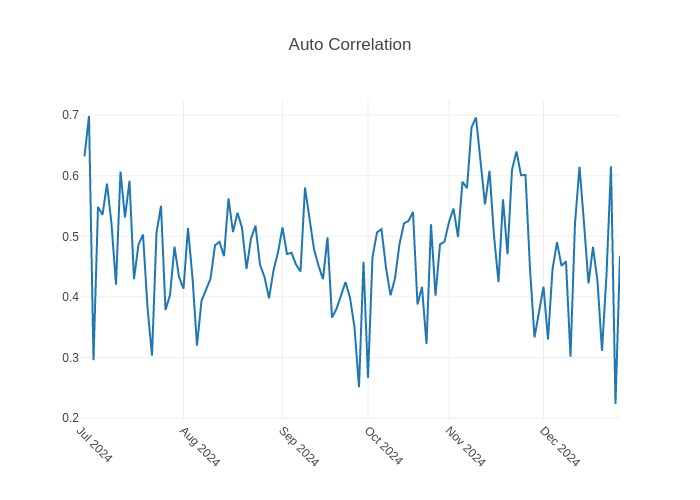

信号预测模型评估

参考文献

- Nie Y, Nguyen N H, Sinthong P, et al. A Time Series is Worth 64 Words: Long-term Forecasting with Transformers[C]//The Eleventh International Conference on Learning Representations.

Except where otherwise noted, this blog's content is licensed under a

Creative Commons Attribution 4.0 International License.

Except where otherwise noted, this blog's content is licensed under a

Creative Commons Attribution 4.0 International License.